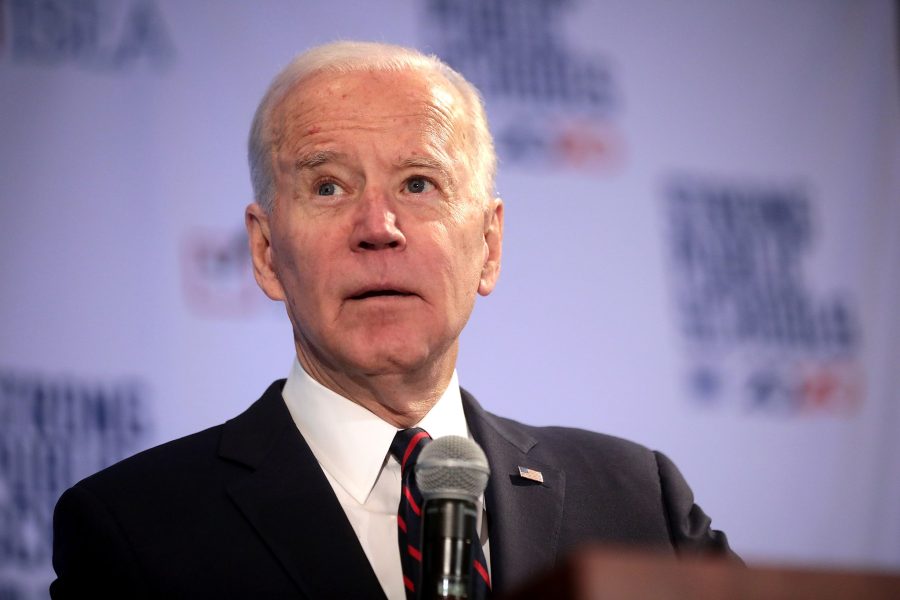

Ferramentas da startup de IA, ElevenLabs, estão sendo responsabilizadas por chamadas automáticas falsas de Joe Biden para eleitores de New Hampshire na semana passada.

Alguns eleitores do estado alegaram ter recebido telefonemas do Presidente dos EUA dizendo-lhes para não votarem nas eleições primárias. Mas embora não esteja claro quem foi o responsável direto pelas chamadas, duas equipes de especialistas em áudio disseram à WIRED que provavelmente foi criado usando tecnologia originada da startup de fechamento de voz Eleven Labs.

A empresa de segurança Pindrop, especializada em ferramentas que identificam áudio sintético, disse em um blog na semana passada que, após analisar as chamadas, as evidências apontavam para a tecnologia da ElevenLabs ou um “sistema que usa componentes semelhantes”.

As ferramentas de IA da ElevenLabs são comercializadas para audiolivros e videogames, mas o público pode se inscrever no serviço pago da empresa e usar uma amostra de áudio para a voz de qualquer pessoa. Sua política de segurança incentiva os usuários a obterem a permissão de alguém antes de clonarem sua voz, mas afirma que a clonagem sem permissão é aceitável para fins não comerciais, incluindo “discurso político que contribui para debates públicos”.

O CEO da empresa, Mati Staniszewski, disse em comunicado na sexta-feira que a ElevenLabs está “dedicada a prevenir o uso indevido de ferramentas de IA de áudio”. O comunicado também disse que a empresa ajudaria as autoridades a tomar medidas em casos de uso indevido.

No entanto, esta não é a primeira vez que as ferramentas da ElevenLabs são acusadas de estar no centro de propaganda política falsa. Em setembro do ano passado, foi alegado que contas do TikTok que compartilhavam teorias da conspiração usando vozes geradas por IA, incluindo a de Barack Obama, estavam usando ferramentas da ElevenLabs.

A ElevenLabs levantou recentemente US$ 80 milhões, com uma avaliação de US$ 1,1 bilhão, em uma nova rodada de financiamento, alcançando o status de “unicórnio”.

O lado negro do conteúdo deepfake

Este é o mais recente incidente de criação de conteúdo deepfake gerado por IA que mostra o lado negro do que esse tipo de tecnologia pode fazer, em meio a novos apelos para regulamentar a indústria.

Na semana passada, imagens falsas sexualmente explícitas de Taylor Swift se tornaram virais no X antes que a plataforma passasse a bloquear pesquisas pela popstar em uma tentativa de impedir a circulação das imagens.

Com o áudio, o vídeo e agora o áudio tendo o potencial de serem mal utilizados de maneiras tão prejudiciais usando a tecnologia de IA, os recentes apelos do congressista Tom Kean para que o Congresso aprove dois projetos de lei que ele apresentou para ajudar a regular a IA estão se tornando mais pertinentes.